6月20日的华为开发者大会上,华为云计算CEO张平安宣布,新一代昇腾AI云服务全面上线,为大模型应用提供算力支持。昇腾系列已经很难低调了。

4月10日,华为在arXiv上发布了一篇训练Pangu(盘古)Ultra大模型的论文,昇腾的“秘密”开始浮出水面。

这篇论文解析了如何在8192张昇腾芯片上训练出1350亿参数的稠密大模型。在国产芯片上训练出千亿级大模型,昇腾当属国内第一家。

同一天,昇腾CloudMatrix 384超节点面世,欲对标英伟达最新产品GB200 NVL72。所谓CloudMatrix 384,是由384个昇腾NPU、192个鲲鹏CPU联接而成的超级计算单元,堪称大模型训练的“超级大脑”,Pangu Ultra的后训练就是基于它。

一个月后,华为再发Pangu Ultra MoE(混合专家模型)论文。这一次,华为讲述了在昇腾NPU上训练高达7180亿参数的大型稀疏语言模型,参数规模已经是准万亿级别。

两篇论文直接将低调的昇腾推至台前,其训练实力也经过了盘古系列大模型的验证。国内AI推理市场虽百花齐放,但AI训练一直由英伟达制霸。昇腾一系列技术报告的“面世”让英伟达迎来劲敌。

竞争对手的重视和“追捧”,更折射出市场变幻。英伟达创始人兼CEO黄仁勋日前接受媒体采访时表示,华为昇腾CloudMatrix 384超节点,部分性能甚至超过英伟达产品。

昇腾也引发了美国关注,被政策“警告”。对此,华为创始人任正非在近期的一次对谈中说道:“美国是夸大了华为的成绩,华为还没有这么厉害。要努力做才能达到他们的评价。我们单芯片还是落后美国一代,我们用数学补物理、非摩尔补摩尔,用群计算补单芯片,在结果上也能达到实用状况。”

这段话既说明了华为面临的客观挑战,也点出了昇腾突围的核心路径,即系统性工程创新。

虽然算力生态的建设还需要时间,但在2025年,全球AI算力暗流涌动,格局已经悄然生变。黄仁勋隔空回应任正非时说道:“尽管英伟达技术领先一代,但人工智能是一个并行问题,中国可以通过使用更多芯片来弥补单个芯片性能的不足。如果美国不愿参与中国市场,华为有能力覆盖中国及其他地区的市场需求。”

AI算力的竞技场上,从来都是技术更迭,英雄辈出。一位华为专家接受21世纪经济报道记者采访时谈道:“目前scaling law(语言模型中的规模化法则行为)还没有停止,大家都想做大计算规模。我们现在是384,后面也会有更大的超节点。但是做大以后,就面临着复杂度、技术难度指数级提升的问题。相比单卡,我认为系统工程带来的提升会更大,这是当前形势下我们优先努力的方向。”

AI长跑还在继续,回看华为在AI算力产业的布局,我们会发现,昇腾从来都不是横空出世,而是华为在持续创新中跑出的科技范式,系统工程路径、坚持基础研究、重视商业化能力……都是其中的重要组成部分。

从前大家说国内产业“缺芯少魂”,现在芯片和操作系统群雄并起。华为依然是冲锋者,从昇腾到鸿蒙,已经从“能用”向“好用”跨越。昇腾CloudMatrix 384就是集大成者。

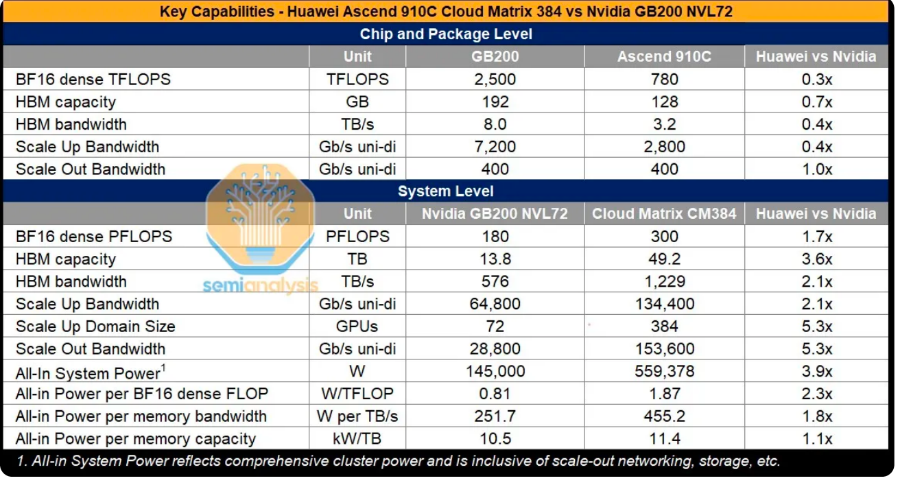

SemiAnalysis发布的报告中,将华为CloudMatrix 384和英伟达GB200 NVL72进行了比较,得出的结论是,拥有五倍数量的昇腾芯片,抵消了其单个芯片仅为英伟达Blackwell芯片性能三分之一的差距。

报告还指出,完整的CloudMatrix系统可以提供300PFLOPs(千万亿次)的密集BF16计算能力,几乎是GB200 NVL72的两倍。凭借超过3.6倍的总内存容量和2.1倍的内存带宽,中国拥有了能够超越英伟达的AI系统能力。

上述华为专家谈道:“以前大家用昇腾,并不认为昇腾很先进,只是因为被美国断供了,没有办法才用昇腾。现在正在转变,昇腾在超节点方面是很先进的,现在很多客户在使用我们的超节点。DeepSeek在昇腾超节点的吞吐大约是每卡1920 TPS,相当于(英伟达)H100的水平,虽然我们单卡算力有点差距,但是系统的性能不亚于它,整体效能领先。”

在上周的华为开发者大会上,张平安介绍,昇腾CloudMatrix 384超节点的吞吐已经提升到2300 TPS。那么,效能究竟如何?

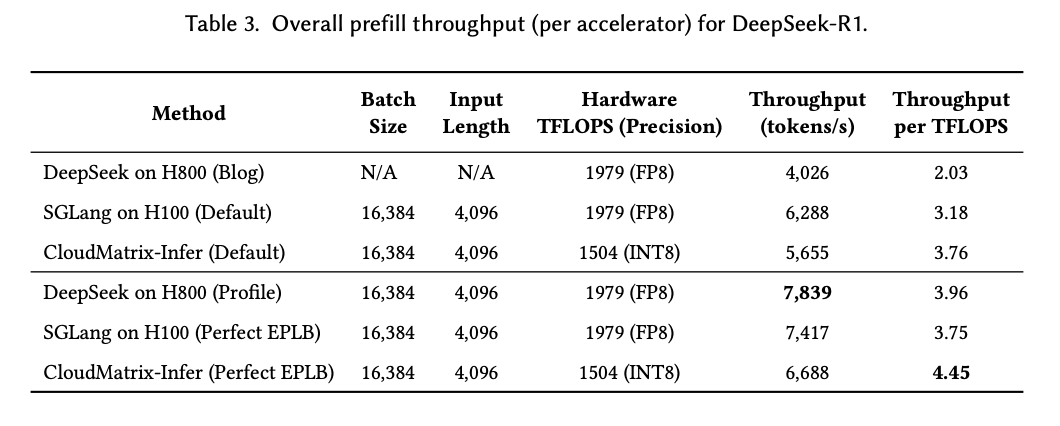

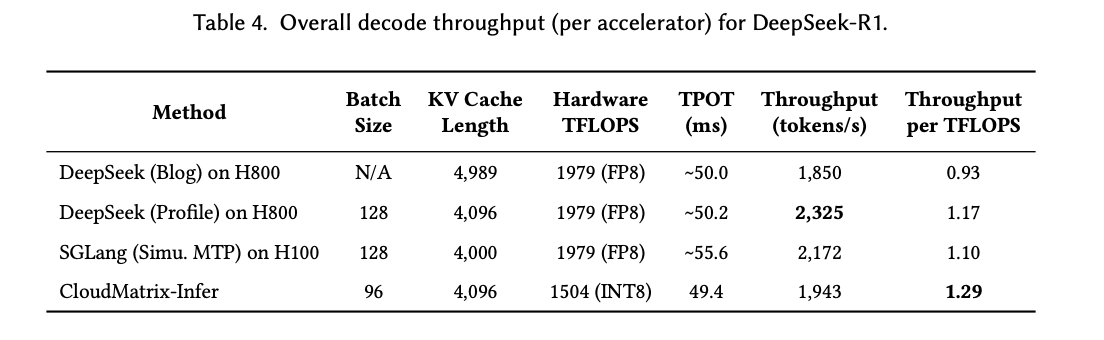

就在6月15日,华为联合硅基流动发布了CloudMatrix 384超节点部署DeepSeek的论文,将CloudMatrix 384和英伟达H100、H800的效果进行对比。数据显示,在DeepSeek-R1的推理中,CloudMatrix 384的算力利用率达到最佳。

(算力利用率等数据对比,图源:论文《Serving Large Language Models on Huawei CloudMatrix384》)

这意味着,在单卡受限的情况下,华为通过超节点创新优化,性能大幅提升,不输英伟达Hopper架构的产品。即便没有和最新的Blackwell架构产品直接对比,华为的追赶已经非常迅速,通过超节点在系统能力上制胜。

事实上,超节点思路并不是华为独家。SemiAnalysis的报告就指出,在2022年,英伟达就宣布了DGX H100 NVL256“Rangerˮ平台,但由于其成本高昂、功耗大、光学收发器和两级网络能力限制等因素,最终决定不投入生产。

这也侧面反映,华为重新设计全对等的高速互联架构,扩展联接数百个芯片,绝非易事。而华为的“大力出奇迹”,是建立在通信、光学、热学、基础软件等多领域的技术积累之上。

通信产业是华为的Kaiyun全站网页立身之本,全球市场上也无出其右。当芯片持续堆叠,将上百个芯片串联时,通信互联反而成为了关键所在。英伟达有独家的NVLink互联技术,华为则重新定义了全对等的互联总线,颠覆了以前主从式的结构,统一了通信协议,互通就不需要转换,提升了有效载荷。

更通俗一点说,华为的新架构相当于在芯片内有一条“超级高速路”。各种类型数据都可以统一在这条路上传输,不再绕小路、不再换车、不再塞车。这也是华为的一项核心创新,解决了模型训练和推理过程中的数据流瓶颈,是Cloud Matrix 384能跑通千亿级MoE模型的关键基础技术。

当然,CloudMatrix 384超越、昇腾崛起的背后,是诸多技术创Kaiyun全站网页新的集合。其中,就包括了超级并行、负载均衡、鲲鹏昇腾协同优化、RL训推共卡,等等。这是一整套软硬件的系统性工程,所展现的是“系统最优”的综合能力。

“系统工程带来的提升会更大,”上述华为专家向记者阐释道,“以单芯片提升路径来看,从7纳米到5纳米、3纳米、2纳米,每代带来的性能提升不超过20%。我们通过高效的超节点系统,把芯片算力利用率提上去了。”

他举例道,MoE大模型训练,以前MFU(算力资源利用率)是30%,这是业界平均水平,“我们最新公布的数据是提升到41%,实验室超过45%。从30%提升到45%,利用率相当于提升了50%。通过系统工程的优化,资源的高效调度,一定程度弥补了芯片工艺的不足。”

近年来,面对外部制裁,华为在硬件和软件产业链上双管齐下。面对眼前的挑战与短板,必须要寻找“弯道超车”的道路。当限制越发严苛,摩尔定律走向尽头,全球芯片企业的角逐愈演愈烈,华为转向工程化、系统化的突围思路逐步显现端倪。

在2024年的华为全联接大会上,华为轮值董事长徐直军曾谈到算力发展。他坦言,立足中国,只有基于实际可获得的芯片制造工艺打造的算力才是长期可持续的,“因为人工智能正在成为主导性算力需求,促使计算系统正在发生结构性变化,需要的是系统算力,而不仅仅是单处理器的算力。这些结构性变化,为我们通过架构性创新,开创出一条自主可持续的计算产业发展道路,提供了机遇。”

在华为专家看来,仅从单卡性能来看,昇腾和英伟达相比有差距,但是训练大模型都需要大系统,纯粹比单卡没有意义。通过超节点系统的有效调度,昇腾系统能效不比英伟达差。

去年以来,昇腾算力体系的成效逐渐显现。据透露,Pangu Ultra千亿稠密大模型在2024年就已经训练完成,而718B的MoE大模型训练从今年2月底开始,4月底就基本训练结束。这样高效的训练成果,受益于前期的庞大积累。

上述华为专家说道:“系统工程不是我们独有的选择,而是做计算系统的共同努力的方向,目的都是把系统做到最优。CloudMatrix 384超节点里面有384个卡,这些卡要连在一起像一台计算机一样高效的工作,这就是很复杂的系统工程。”

他进一步指出,超节点系统不仅仅是计算,而是包括计算、内存、通信、存储、架构、调度、并行、散热、供电和高速互联等,“超大规模MoE模型的训练就是一项复杂的系统工程,挑战很大,深入下去就会发现到处是拥塞,串行,等待,很大情况是资源不匹配,还有一些则是重复计算或重复数据搬运,藏着巨大的改进空间。”

在内部看来,华为深耕电子信息产业数十年,在硬件工程和基础软件方面有很深的积累,有能力把复杂系统做好。

华为专家举例道,比如,通过光的应用能力,能把带宽做大;又比如,凭借网络能力,根据计算系统的需求,重新定义了对等架构的互联总线,颠覆了以前主从式的结构,统一了通信协议,引入了高效的语义通信;再比如,华为操作系统的能力,可以根据超节点计算的要求进行创新,实现资源池化、超级并行、业务驱动的最佳资源匹配。

他向记者总结道:“我们基于中国的现实情况,解决中国的现实问题。我们不简单追求单点技术的路线,而是以面积换能力、以堆叠增容量、以集群扩规模,通过超节点的系统工程创新,实现规模算力的领先和效能的最优。”

近期,昇腾技术体系逐步走向开放和透明。在不断公开的论文与一系列技术报告中,外界可以一窥这套复杂系统背后的工程思维与方法论。

一位华为专家表示:“解决这些超复杂系统的问题需要懂理论,如系统论、控制论、信息论、计算数学等;同时,我们通过数学的方法对计算系统进行建模、仿真,想办法把每一部分都用起来,做到不浪费,各个部分完美配合,高效协同。最终体现在系统的指标上,如训练的效率、推理的性能、系统的可用度、集群的线性度、算力的利用率等。”

“华为内部有一个算力会战,把华为云、模型、底座、芯片、硬件工程、基础软件的人集结在一起,跨部门作战,深度协同。算力基础设施现在是复杂的系统,我们把各个部分打通了。”专家指出,华为构建了这样的环境和机制,能够产生协同效应和系统工程的整合,实现了“大杂烩”技术的有效利用和协同创新。

在算力底座竞争力上的投入,华为同样毫不吝啬。据华为专家介绍:“华为在算力上的投资是很大的,加起来超过万人,华为云、计算产品线实验室,还有网络产品线、光产品线都参加会战了,打造这样复杂先进的超节点系统,聚集了华为几十年积累的能力。”

事实上,从芯片、操作系统、开发工具、大模型等,华为都有布局。尤其是此番昇腾和大模型的紧密合作,更能体现其“软硬兼施”的体系化优势。华为专家说道:“我们既做算力基础设施,也做基础大模型。做模型和做算力底座的团队是深度协同的,通过模型的训练,发现其中的挑战和算力问题,牵引算力的改进,算力的改进又支撑模型训推的进步。没有这样的牵引和支撑驱动机制,可能都不能发现深层次的问题,这对昇腾竞争力构建和支持客户用好昇腾很关键。”

另一方面,在机制保障的底层,依然是拼研发基础。众所周知,华为每年在基础研究上的投入巨大。2024年,华为研发投入达到1797亿元,约占全年收入的20.8%,近十年累计投入的研发费用12490亿元。据了解,在华为研发体系中,2012实验室是整个公司技术体系的底座,包括理论、技术、工程、研发能力,以及公司下一代平台等。2012旗下有86个实验室,每一个都致力于在某一领域持续做强,实现技术扎到根,做到“根深”。

华为专家还告诉记者:“基础研究我们是很开放的,除了自己研究,也大力资助高校,与高校联合研究和技术合作。我们的科学家、专家也会深入业务的会战,把理论和技术应用到业务中,创造性解决实际的业务难题,提升产品竞争力,创造商业价值,实现‘叶茂’。我们把研究和创新有机地结合起来,实现‘根深叶茂’。”

研发创新的同时,在产品与客户之间,华为也建立了快速响应机制。据悉,华为现在对关键信息基础设施行业的客户,派了中高级专家组成的“小巧灵突击队”,到一线现场支持他们用好昇腾。

华为专家坦言:“希望大家不是因为担心断供才用华为,也不是说担心安全才用国产算力。我们是通过自己的实力赢得客户,而且对行业客户的支持更有力。”

从底层架构到模型协同,从系统工程到组织机制,昇腾所代表的,不仅是一颗芯片的竞争力,更是华为以“会战机制”打通各条技术战线,在持续的研发工程中跑出来的一套自主科技范式。而且基于这一套长期的体系,创新范式能够在内部不断复制、迭代出新的技术能力。

从华为体系来看,在算力层面,发展了昇腾AI芯片和服务器CPU鲲鹏芯片,并且围绕鲲鹏和昇腾构建新的计算生态。它们是华为最核心的AI算力旗舰,正助其努力为世界提供算力新选择。

多年前,华为就提出了计算战略,瞄准人工智能的算力底座。随着近两年生成式AI崛起,尤其是昇腾算力体系加速爆发,华为也欲在新一轮的AI浪潮中占据主导地位。

在AI竞赛场上,昇腾从2019年面世以来就是不可忽视的一支力量。如今,昇腾早已不是当年单卡的概念,已经从加速卡、集群,演进到一整套AI软硬件体系。

同时,昇腾所代表的算力底座,是华为“百模千态”战略的核心部分。2023年9月,在华为全联接大会上,华为发布全面智能化(All Intelligence)战略,并多次提到了“使能百模千态,赋能千行万业”的概念。

目前,昇腾算力对阿里千问、DeepSeek等国内大模型都开放支持。虽然和英伟达的生态成熟度存在差距,但是市场正在发生结构性变化,新的机会显现。

“我们在生态方面劣于英伟达CUDA生态,尤其是前几年。”一位华为专家坦言,但是,“2024年、2025年以来,情况有所好转。”

这种变化背后有两条关键技术线索。其一是模型架构的收敛。“业界以前的算子有几万个,加上衍生的算子有十万以上。现在,主流的模型聚焦到Transformer、Diffusion以后,核心的算子大概就几百个。”

算子数量的“收缩”,为昇腾生态的突破提供了可行窗口。华为专家介绍:“我们很快开发补齐了高质量、高性能的基础算子,然后把这些算子深度开放给客户。头部客户都具有很强的技术能力,能在基础算子上开发自己的算子和算法,很快就适配了他们的模型和应用。不管是DeepSeek MoE模型,还是像千问、Llama等开源模型都是支持的。现在算子就不缺了,最大的问题就解决掉了。”

除了算子优化,在集群架构和系统层面,昇腾也取得了实质性进步。“集群和超节点方面的进展很大。训练万亿大模型挑战很多,我们碰到问题就解决问题,产生了很多创造性的技术。”华为专家指出。

这一切,都推动着昇腾迈入“世界级”的赛道。专家表示:“昇腾算力能够训练出世界一流的大模型,训练高效率,推理高性能,系统高可用。”

为进一步降低客户门槛,昇腾团队还推出了“Day0迁移”工具。上述专家说,“当前国内很多大模型是基于英伟达训练,用华为昇腾做推理。所以,我们就开发了一个工具,把训好的模型一天之内迁移到华为的昇腾上,推理一键部署。”

生态的构建任重道远,但是,不论华为,还是英伟达,进化的趋势是相似的。大家竞争的焦点都已经从芯片单点能力,转向系统级综合效能。英伟达说要从芯片公司转型为AI基础设施企业,华为同样也不再强调单卡芯片,而是系统级能力。一场AI基建的新型赛事已经启动。

随着竞争趋势的变化,算力市场的格局也在演变。以AI服务器领域为代表,英伟达目前还是一家独大,不过追赶者众多且凶猛。

关于全球市场,TrendForce集邦咨询研究经理龚明德表示:“从AI芯片厂商供货AI服务器的占比来看,今年英伟达估计占7成左右,AMD的占比约为8%,Others部分——包括华为、国内的业者,以及在北美其他市场的CSP,占两三成左右。”

而在中国市场上,国产芯片占比或将较为显著上升。集邦咨询向21世纪经济报道记者提供的数据显示,2024年,中国AI服务器市场的外购AI芯片中,英伟达、AMD、英特尔等占比为63%;华为和寒武纪等国内供应商约占23%;云厂商自研的ASIC占比最小,近14%。

集邦咨询预计,2025年国内AI芯片供应比例将增至40%。“其中比较大的变化是针对外购的部分,尤其是英伟达等企业部分,今年估会降到41.5%。去年,互联网业者都有一些风险意识,提前拉货;今年,H20芯片尤其在第二季度后将受新出口禁令影响,占比下修。”龚明德表示。

这种趋势的背后,是政策、供需和技术演进的综合作用。华为所构建的昇腾体系,正在逐步从“替代”走向“优选”,成为AI大模型产业链中具有自主性、可控性与系统协同性的基座。昇腾也代表着华为在AI算力市场上的系统性突围,一场围绕“生态、系统、工程”的长期竞赛,来到新的赛点。

资本市场重要信息!吴清陆家嘴论坛开出“1+6”新政:未盈利企业上市利好来啦

Copyright © 2024 开云沙盘有限公司 版权所有 备案号:蜀ICP备19012180号 网站地图